Tel:18180666168

发布:2023-02-24 09:32:04

阅读:43

近日,LightCounting(LC)对Photonics West的CPO论坛讨论发表评论。在今年的Photonics West会议上,参会者达到22000人,光通信并不是讨论中心。然而,在共封装光学(Co-Packaged Optics,CPO)论坛上,大家提出了一个重要的问题:如果网络只占云数据中心总功耗的2-3%,我们为何要担心光模块功耗不断增加?

Coherent的Vipur Bhatt展示了两年前发表在《Science》杂志上的一篇文章中的数据,数据显示,大家对数据中心日益增长的功耗的担忧被高估了。这项研究比较了2010年和2018年所有数据中心的功耗,仅增长了约8%。将这一趋势推至2022-2023年,表明由于数据中心效率的持续提高,增长幅度很小,为2-3%。

这种改善主要有两个原因:

1. 将工作负载从企业数据中心转移到由云公司运营的大型数据中心,这要高效得多。

2. 占90%功耗的服务器和内存的效率稳步提高。

2012年,网络消耗的电力仅占1%,2018年占2%,到2022年约占3%。我们需要在意它吗?

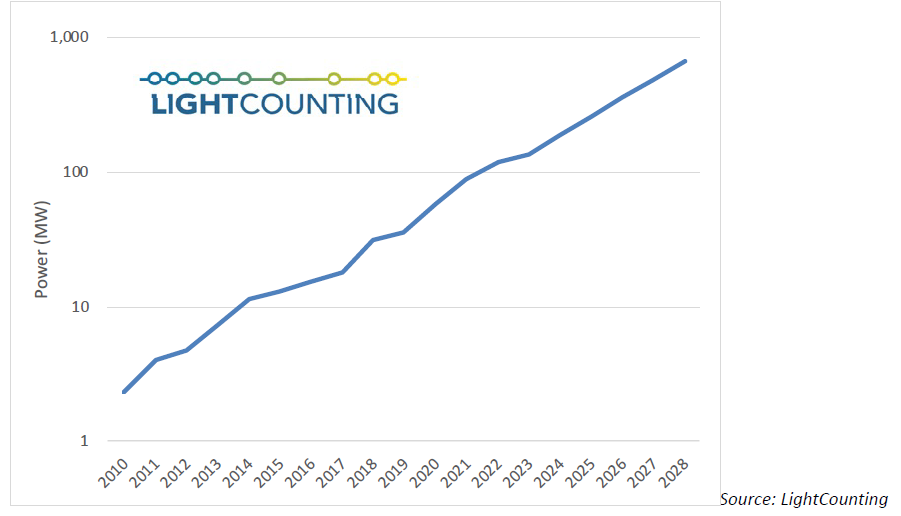

下图展示了LC对云数据中心部署的光模块功耗的计算(以年度部署计算,而不是累积计算)。请注意,纵坐标刻度是对数刻度。在对数刻度的图表中,任何直线都该引起重视,因为它代表着指数级增长。等怀疑论者意识到这一点之时,解决电力消耗问题可能为时已晚。

根据这一分析,2018-2022年部署在云数据中心中的光模块的总功率加起来达到330MW或1.2TWh,略高于目前云数据中心总功耗的1%。问题是,到2028年,光学器件预计将占其中的8%以上。该分析说明了可插拔光学器件的功率效率不断提高:从100G模块中的35pJ/bit提高到800G收发器中的20pJ/bit。

到2028年,云数据中心的光学器件将占到总功耗的8%,我们是否应该对此感到担忧?是的,我们应该。云数据中心运营商在为其设施提供更多电力方面面临重大限制。如果光学器件消耗更多的功率,他们将被迫减少分配给服务器和内存的功率预算。

一个更重要的问题是,人工智能(AI)集群的设计受到光连接的高功率和成本的严重限制。英伟达称,如果不受功率和成本的限制,他们现在可以多使用32倍的光学器件。AI模型的执行需要大型GPU阵列,如果供应商能够降低其功耗和成本,高带宽光连接将是最佳解决方案。

Ayar Labs、Broadcom、IBM和Ranovus的下一代CPO设计预计将达到2-3pJ/bit的能源效率。Rajeev Ram教授是Photonics West的全体会议发言人,也是Ayar Labs的联合创始人,他声称0.1pJ/bit是现有每通道200G技术可以达到的。他在麻省理工学院的团队正在研究低压调制器和改进的探测器,目标是使互连功耗达到0.001pJ/bit或更低。麻省理工学院的一些解决方案将使用非常低的数据(Mbps)速率来降低功耗。Ayar Labs的方法也是基于使用较低速度(64Gbps)的NRZ光学器件来达到2pJ/bit。他们能否以112G每通道NRZ使功耗低于1pJ/bit还有待观察。

我们行业正处于十字路口。我们可以保持现状,继续使用可插拔光学器件,并逐步改进它们。AI集群的扩展速度不会那么快,但会有其他方法来优化AI模型,以满足有限网络带宽的限制。另一种选择是冒险开发新的光学技术,采用新的封装和光纤耦合设计,从根本上改善成本和功率效率。这种方法将极大地促进AI的发展,并将我们的行业提升到一个全新的水平。这条道路令人兴奋,但怀疑论者认为这非常具有挑战性的。他们也没错,然而,错过这个机会将是一个错误。

原文:LightCounting :: Our industry is at a crossroads

网址:https://www.lightcounting.com/newsletter/february-2023-our-industry-is-at-a-crossroads-269